AI, GDPR och framtidens digitala möjligheter

8 september, 2025

AI har på kort tid blivit en självklar del av vår vardag. Verktyg som ChatGPT, Google Gemini och Copilot används i många branscher. Men vad händer egentligen med informationen du matar in, och hur påverkar GDPR och den nya AI-förordningen dina möjligheter att arbeta tryggt med artificiell intelligens?

I detta inlägg går vi igenom:

- Hur GDPR påverkar användningen av AI

- AI-förordningen och vad den innebär

- Vad som händer med information i ChatGPT

- Ett verkligt exempel, Samsung och AI-läckan

- IMY:s regulatoriska sandlåda

- Att göra och att undvika när du använder AI

- En blick framåt

Hur GDPR påverkar användningen av AI

GDPR reglerar hur personuppgifter får behandlas, och det gäller oavsett om du använder ett CRM-system, Excel eller ett AI-verktyg. En personuppgift kan vara ett namn eller en adress men också uppgifter som i kombination kan göra någon identifierbar. Detta betyder att även information som vid första anblick verkar neutral kan omfattas av GDPR om sammanhanget avslöjar något om en person.

Integritetsskyddsmyndigheten har varit tydlig med att AI inte är något undantag. Reglerna gäller fullt ut även för generativ AI. Det innebär att allt från enkla kundmejl till interna anteckningar måste hanteras med samma försiktighet som i andra system.

AI-förordningen och vad den innebär

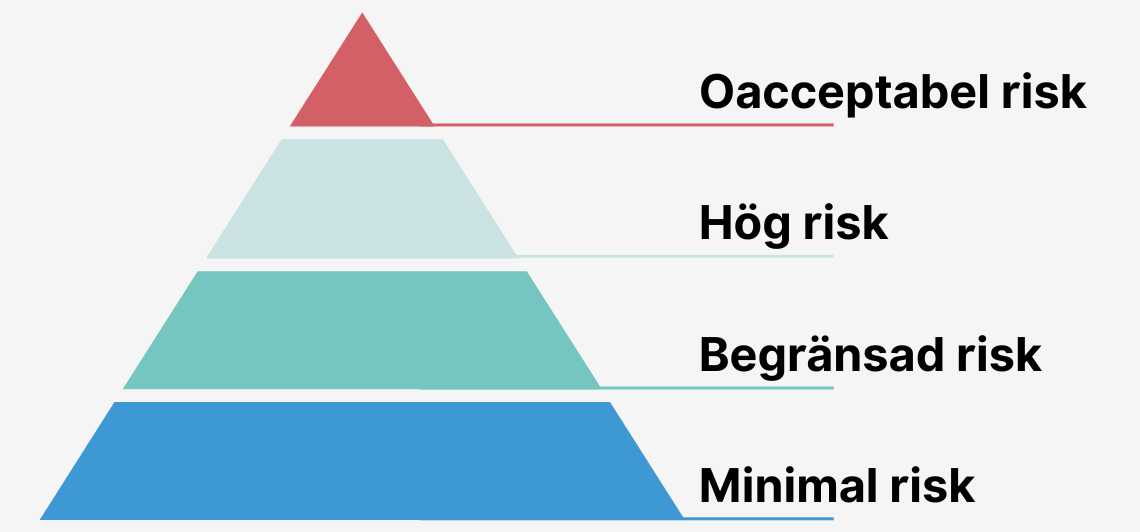

Sommaren 2024 började EU:s nya AI-förordning gälla. Det är världens första heltäckande lagstiftning för artificiell intelligens och den blir fullt genomförd under 2026. Syftet är att skapa tydligare regler, minska riskerna och samtidigt bygga förtroende för tekniken.

Förordningen delar in AI-system i olika risknivåer. Vissa klassas som låg risk, andra som hög risk och en del förbjuds helt. AI som används i rekrytering, utbildning och vård hör till de högriskklassade områdena eftersom besluten som tas kan få stor påverkan på enskilda människors liv. AI som används för social scoring eller manipulation är helt förbjudet inom EU.

Ett annat centralt krav är transparens. Alla användare ska veta när de interagerar med AI och när material är AI-genererat. Detta gäller både text, bild och ljud. Företag som utvecklar eller använder AI måste kunna visa att systemen är säkra, att datan är korrekt och att användarna inte riskerar att vilseledas.

Konsekvenserna av att bryta mot reglerna är allvarliga. Företag kan bötfällas med upp till 35 miljoner euro eller sju procent av den globala omsättningen, beroende på vilket belopp som är högst. På så sätt markerar EU att artificiell intelligens inte är ett område där man kan experimentera fritt utan ansvar. AI ska utvecklas på ett sätt som både gynnar innovation och skyddar människor.

Vad som händer med information i ChatGPT

När du använder ChatGPT eller liknande tjänster skickas din text till leverantörens servrar. Ofta finns dessa utanför EU. Informationen sparas och används för att generera ett svar till dig. I gratisversionen av ChatGPT kan informationen dessutom användas för att träna modellen vidare. Du som användare har mycket liten kontroll över hur länge informationen sparas eller vem som i framtiden kan få tillgång till den.

En viktig detalj är att OpenAI, företaget bakom ChatGPT, inte omfattas av det dataöverföringsavtal mellan EU och USA som idag gäller. Google omfattas av avtalet, men även där krävs en tydlig rättslig grund innan personuppgifter kan hanteras. Många användare tror att tjänsterna själva garanterar GDPR-efterlevnad, men det ansvaret ligger alltid på den som använder verktyget.

När AI blev ett problem för Samsung

I april 2023 hamnade Samsung i en situation som snabbt blev ett globalt samtalsämne. Allt började med att några anställda använde ChatGPT för att lösa vardagliga problem. En ingenjör klistrade in delar av källkod för att få hjälp med felsökning. En annan anställd matade in interna skript för att optimera processer. I ett tredje fall laddades mötesanteckningar från en strategisk diskussion upp för att få en sammanfattning. Tre små handlingar som för de anställda kändes harmlösa, men som i själva verket satte hela företagets informationssäkerhet på spel.

Problemet var att gratisversionen av ChatGPT använde inmatad data som träningsunderlag. Det innebar att informationen inte kunde garanteras vara privat. Källkod, interna rutiner och strategiska diskussioner riskerade att i teorin bli en del av framtida svar till andra användare, eller på annat sätt hamna utanför företagets kontroll. För ett globalt teknikbolag var riskerna enorma. Händelsen fick internationell spridning och blev snabbt en påminnelse för andra organisationer om att AI inte är ett neutralt anteckningsblock. Du kan läsa mer i en artikel hos The Verge.

Vilka risker de stod inför

Källkoden som matades in kunde avslöja tekniska lösningar och affärshemligheter. Mötesanteckningarna gav insyn i strategiska planer som konkurrenter aldrig skulle få tillgång till annars. De interna skripten visade hur Samsung arbetade med sina processer och system. Sammantaget handlade det inte bara om ett par misstag utan om risker som kunde påverka både konkurrensfördelar, relationer till kunder och efterlevnad av lagar som GDPR.

Så reagerade Samsung

Samsung agerade snabbt. I början av maj 2023 infördes ett förbud för alla anställda mot att använda publika AI-tjänster på företagets enheter och nätverk. Samtidigt började företaget utveckla ett eget internt AI-verktyg för textanalys och kodgranskning. Poängen var enkel: AI skulle fortfarande kunna användas men på ett sätt där all data stannade inom företagets egna system. Dessutom utbildades personalen om riskerna och företaget gjorde det tydligt att brott mot den nya policyn kunde få konsekvenser. På kort tid blev incidenten ett av de mest uppmärksammade exemplen på varför tydliga riktlinjer för AI är helt nödvändiga.

IMY:s AI-sandlåda

Samtidigt som företag som Samsung brottas med riskerna arbetar svenska myndigheter aktivt för att skapa tryggare sätt att använda AI. Ett av de mest spännande initiativen är Integritetsskyddsmyndighetens regulatoriska sandlåda. Det är en plattform där företag och organisationer får möjlighet att presentera sina AI-idéer i tidigt skede och få dem granskade ur ett dataskyddsperspektiv. Sandlådan är inte en frizon där reglerna pausas utan en plats där man kan testa idéer i en kontrollerad miljö och få vägledning innan de används på riktigt.

Organisationer som deltar får chansen att visa upp sina AI-lösningar som om de redan vore i drift. IMY granskar hur lösningarna hanterar personuppgifter och ger konkret återkoppling. På så sätt kan företag tidigt förstå vad som fungerar, vad som måste justeras och hur man kan utveckla AI på ett sätt som både är innovativt och följer GDPR. Initiativet har fått stor uppmärksamhet eftersom det inte bara hjälper enskilda aktörer utan också skapar lärdomar som andra kan dra nytta av.

Under 2024 deltog IMY i ett pilotprojekt tillsammans med Bolagsverket, Skatteverket och Arbetsförmedlingen. Där testades praktiska AI-case för att se hur sandlådor kan användas som ett stöd i Sverige när EU:s AI-förordning implementeras. Arbetet har visat att det inte alltid är enkelt men att det är nödvändigt för att hitta rätt balans mellan innovation och integritet. Regeringen har dessutom föreslagit att IMY ska få extra resurser för att kunna bygga ut sandlådan och därmed stötta fler organisationer som vill utveckla AI på ett ansvarsfullt sätt.

Så använder du AI rätt

AI kan ge stora fördelar i vardagen, men bara om det används på ett medvetet sätt. Här är några riktlinjer som hjälper dig att dra nytta av tekniken på ett säkert sätt.

Att göra:

- Låt AI vara ett stöd för idéer, inspiration och enklare bearbetning av texter, inte ett verktyg för att hantera känsliga uppgifter.

- Testa dina prompts med anonymiserad eller påhittad information så att inga riktiga personer eller kunder riskerar att exponeras.

- Inför en tydlig AI-policy i organisationen så att alla vet vilka regler som gäller och vad som är förbjudet.

- Se till att allt material granskas av en människa innan det publiceras eller används i skarpa sammanhang.

Att undvika:

- Lägg aldrig in personuppgifter som namn, adresser eller kundlistor i publika AI-tjänster.

- Ladda inte upp interna dokument, mötesprotokoll eller annan information som skulle skada företaget om den hamnade i fel händer.

- Tro inte att AI-tjänsten automatiskt följer GDPR. Det är alltid du och din organisation som bär ansvaret.

En blick framåt

AI är redan en del av vardagen och det är tydligt att utvecklingen bara kommer att fortsätta. Men tekniken är inte utan risker. Allt som matas in i AI-verktyg kan lagras, analyseras och i vissa fall bli tillgängligt utanför den egna organisationen. Samsungs erfarenheter visar hur snabbt det kan gå fel, samtidigt som IMY:s sandlåda visar att det finns vägar framåt där innovation och dataskydd kan gå hand i hand.

Med EU:s AI-förordning får vi nu en tydligare spelplan. Lagarna kommer att skapa mer struktur men också ställa högre krav på hur vi använder AI i arbetslivet. Frågan är därför inte om vi ska använda AI, utan hur vi kan göra det på ett sätt som bygger förtroende, skyddar känslig information och samtidigt låter oss dra nytta av tekniken. Den som hittar balansen mellan innovation och ansvar kommer att stå starkast i den digitala framtiden.

Vill du komma i kontakt med oss?

👇 Klicka här 👇